Procesorji po meri

Podatkovni centri. Nekakšen temelj naših sodobnih digitalnih ekonomij. Farme omrežnih, diskovnih sistemov, pomnilnikov in seveda procesorjev. Ti že leta predstavljajo najdražjo komponento. Naše domače in službene naprave so sicer še vedno opremljene z močnimi računskimi čipi, katerih ponudniki še vedno bijejo vihravo tržno bitko. A kot vam je verjetno jasno, se velika večina stvari dandanašnji izračuna nekje drugje, nam pa na zaslonu prikaže zgolj rezultat. In ta »drugje« zato postaja neskončno pomemben.

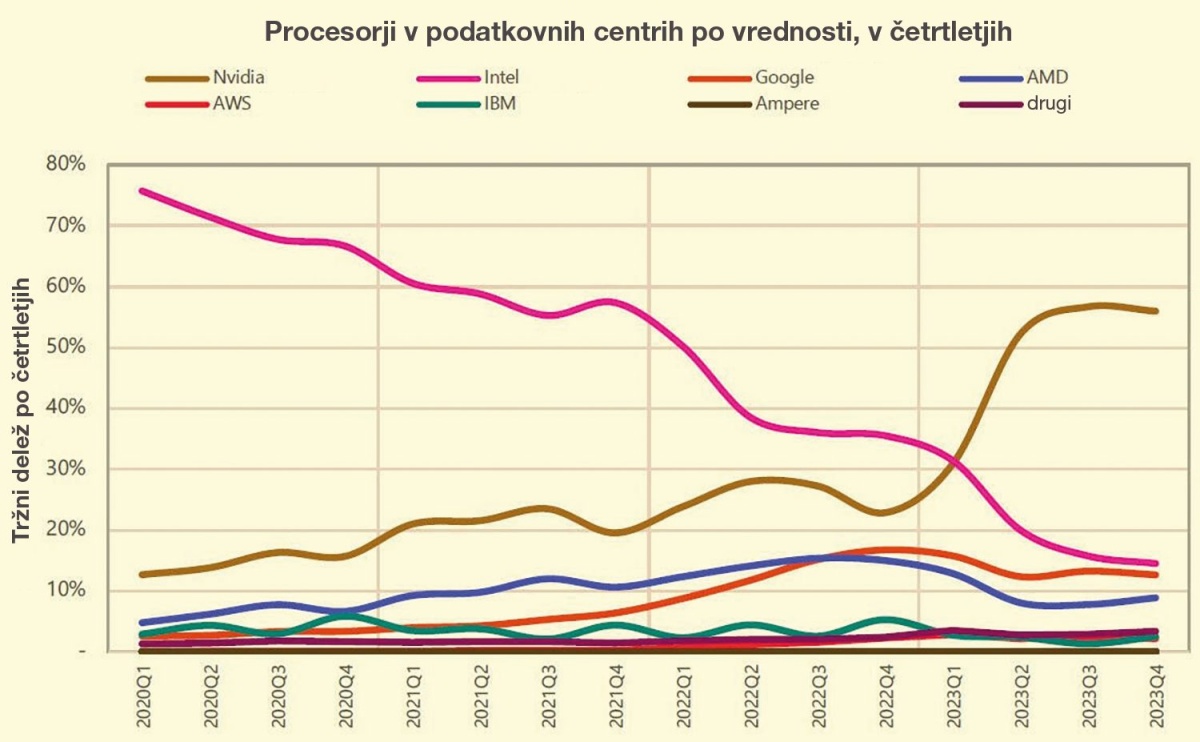

Procesorji za podatkovne centre bodo zato, kot si lahko predstavljamo, v naslednjem desetletju big »biznis«. Napovedi podjetja FMI kažejo, da se bodo prihodki ponudnikov v tem času skoraj podvojili, povprečna letna rast sektorja pa naj bi v tem času znašala 5,8 odstotka. Za primerjavo, branža je med 2019 in 2023 zrasla za 20 odstotkov, povprečna letna rast pa je znašala 4,8 odstotka. Vse skupaj je poganjalo več fenomenov, med njimi zagotovo računalništvo v oblaku, ob tem pa premetavanje velikih količin podatkov (t. i. big data), zadnja leta se je v vrsto postavila še požrešna umetna inteligenca.

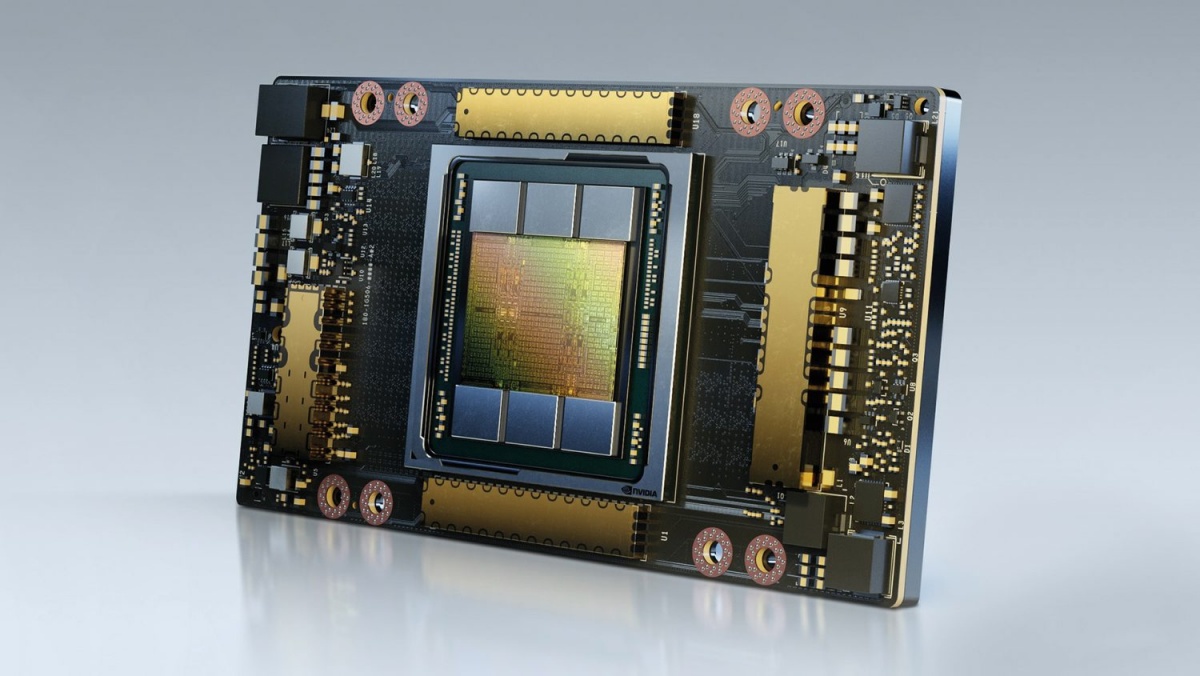

Nvidia je bila in ostaja ključni dobavitelj čipov za umetnointeligenčne strežnike; še več, podjetja so morala zanje dobesedno tekmovati, njihova cena pa je zaradi tega skokovito narasla. Za predstavo: OpenAI je pred slabima dvema letoma za komercializacijo ChatGPT potreboval več kot 30.000 Nvidijinih GPU A100.

Medtem ko je Nvidia hitela z izdelavo čim več čipov, da bi zadostila povpraševanju, ki jo je popeljalo v klub podjetjih, vrednih več kot bilijon dolarjev, so velika tehnološka podjetja začela iskati rešitve znotraj lastnih inženirskih oddelkov – da bi prihranila denar in morda prevzela tudi pobudo pri strojni opremi na tem novo porajajočem se področju.

Po meri

Zlasti ponudniki storitev v oblaku se zavedajo, da bodo vedno bolj zadolženi za poganjanje aplikacij in storitev, ki jih uporabljamo vsak dan. Tradicionalni CPU, ki jih izdelujejo podjetja, kot sta Intel in AMD, so zasnovani za splošno uporabo in pogosto niso optimizirani za specifične naloge v oblaku. Ponudniki teh storitev so zato že pred desetletjem začeli razmišljati o razvoju lastnih procesorjev. No, recimo jim raje koprocesorji, ukrojeni po meri za specifične naloge.

Nvidia je bila s svojimi pospeševalniki A100 nekakšna začetnica AI norije.

Izraz ASIC (Application Specific Integrated Circuit) se je sicer začel pojavljati že v prazgodovini računalništva, a docela nova era je napočila na Googlovi konferenci I/O 2016, ko je Google javno predstavil svojo prvo različico tenzorjev (Tensor Processing Unit – TPU). Googlovi TPU temeljijo na specifični arhitekturi, optimizirani za izvajanje operacij s tenzorji – matematičnimi strukturami, ki so ključne pri obdelavi podatkov v globokem učenju. Optimizirani so za uporabo z Googlovimi algoritmi za strojno učenje, zlasti z njihovo priljubljeno knjižnico TensorFlow. Pri Googlu so javnosti tedaj še zaupali, da tenzorji že kako leto ali dve po tihem poganjajo njihove strežniške farme s področja strojnega učenja.

Če torej povzamemo razloge: razvoj lastnih procesorjev omogoča podjetjem, da optimizirajo svoje operacije že na ravni strojne opreme. To pomeni, da lahko procesorji bolje obvladujejo specifične obremenitve, ki so značilne za posamezno podjetje, kot so velike količine transakcij, obdelava velikih podatkovnih zbirk in izvajanje kompleksnih algoritmov. Prilagojeni procesorji lahko ponudijo izboljšano zmogljivost, energetsko učinkovitost, pod črto pa zmanjšajo stroške delovanja. Poleg tega po meri izdelani procesorji omogočajo večjo varnost. Z oblikovanjem čipa, ki je prilagojen posebnim varnostnim zahtevam, lahko podjetja zagotovijo, da so njihovi sistemi bolj odporni proti zunanjim grožnjam in napadom. To je še posebej pomembno v dobi, ko so kibernetski napadi vse pogostejši in bolj sofisticirani.

Torej, Google

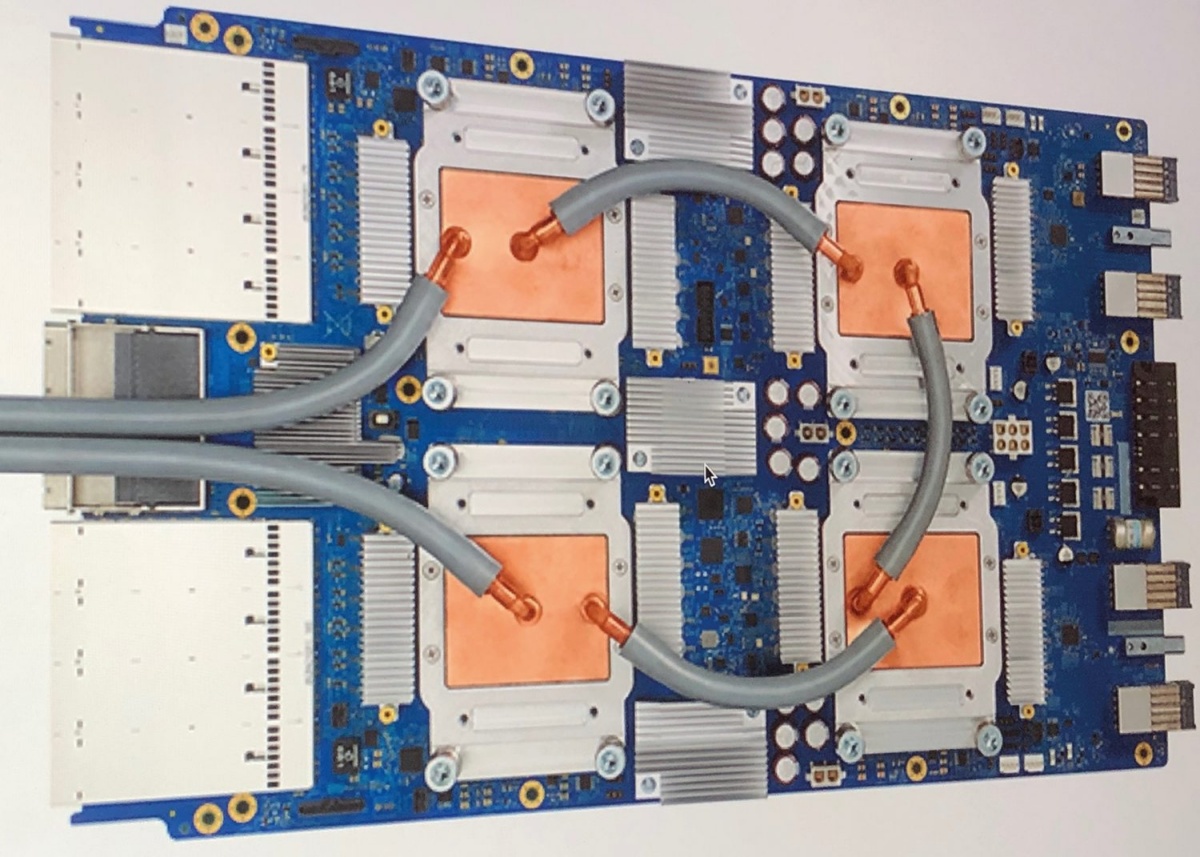

Googlove enote TPU so doživele več generacij, vsaka pa je prinesla izboljšave v zmogljivosti, učinkovitosti in razširljivosti. V podjetju so jih v prvi vrsti zasnovali za lastne potrebe, so pa nekatere modele pozneje ponudili tudi na trgu. Čipe kompletirajo v posebne kapsule (angl. pods), ki se skupaj s hladilnim elementom namestijo v strežniške omarice. Kapsula z najnovejšimi Trilliumi bo lahko vsebovala do 256 čipov. Google seveda nima lastne proizvodnje čipov, v ta namen se je že pred leti povezal z Braodcomom.

Googlov prvi TPU, prvi po meri izdelan procesor za inferenčne operacije umetne inteligence.

Prva generacija je bila usmerjena predvsem v inferenčne operacije, kar pomeni, da so bili TPU uporabljeni za izvajanje sklepov strojnega učenja. Ta generacija je bila ključna za optimizacijo Googlovih storitev, kot je iskalnik, kjer so bili modeli umetne inteligence uporabljeni za izboljšanje rezultatov iskanja.

Druga generacija TPU je leta 2017 prinesla boljše zmogljivosti za urjenje modelov, poleg že obstoječih inferenčnih zmogljivosti. TPU 2.0 je bil predstavljen tudi kot del storitve Google Cloud, kar je prvim strankam omogočilo dostop do izjemno zmogljivih enot za obdelavo podatkov za lastne aplikacije strojnega učenja. Tretja generacija TPU iz leta 2018 je še dodatno izboljšala zmogljivost in energetsko učinkovitost, pri čemer so bile te enote še posebej primerne za obsežno obdelavo podatkov in urjenje kompleksnih modelov umetne inteligence. TPU 3.0 je omogočil tudi naprednejšo rabo Googlovih storitev umetne inteligence, kar je tedaj demonstriral Google Assistant.

Generacija TPU 4.0 iz leta 2021 in naslednja v5.0 sta bili predstavljeni kot prinašalki bistveno večjih zmogljivosti, zlasti ko gre za urjenje modelov in obdelavo podatkov, po čemer so povpraševale porajajoče se aplikacije umetne inteligence, kot so tiste, ki med vožnjo upravljajo samovozeče avtomobile. Obe generaciji sta med razvojem dobili tudi ekonomski, beri osiromašeni različici, označeni z malo črko e.

Trenutno čakamo na prihod letos maja napovedane šeste generacije, imenovane Trillium. Ta naj bi prinesla impresivno 4,7-kratno povečanje računske zmogljivosti na čip v primerjavi s prejšnjo generacijo. Prav tako se bosta podvojili prepustnost pomnilnika in pomnilniškega podsistema HBM ter pasovna širina povezav med čipi (ICI).

V trajnostnem smislu bodo Trilliumi menda za več kot 67 odstotkov energetsko učinkovitejši kot TPU V5.0e, zato bodo verjetno pomemben gradnik bodočih superračunalnikov. Z uporabo tehnologije Multislice in Titanium Intelligence Processing Units bo moč med sabo povezati na stotine kapsul in na ta način dobiti računsko mrcino z zares veliko petaflopsi.

Kaj pa praktična uporaba? Google je torej že zgodaj predstavil tudi storitev Cloud TPU, ki omogoča podjetjem in razvijalcem dostop do procesorjev TPU prek Googlovega oblaka. Google Cloud TPU omogoča podjetjem, da izkoristijo prednosti enot TPU brez potrebe po vlaganju v lastno strojno opremo. Cloud TPU je še posebej priljubljen med raziskovalci in podjetji, ki razvijajo napredne modele umetne inteligence in želijo z namensko strojno opremo skrajšati čas usposabljanja modelov.

Bodo Trilliumi res 4,7 krat zmogljivejši od pete generacije Googlovih TPU? Odgovor naj bi dobili do konca letošnjega leta.

Kot si lahko mislite, enote TPU brusijo natančnost Googlovega iskalnika s tem, da analizirajo uporabniške poizvedbe in nato ponujajo ustreznejše odgovore. Prav tako analizirajo fotografije v Google Photos in videe na Youtubu. Pred skoraj desetimi leti so na ta način analizirali besedila na materialih njihovega Street Viewa in TPU prvih generacij so to opravili v manj kot petih dneh.

Na TPU 6.0 temeljijo nekateri napredni generativni modeli, denimo Dall-E in Chat GPT, ki se uporabljajo za ustvarjanje besedil, slik in drugih vsebin.

Amazon in gravitoni

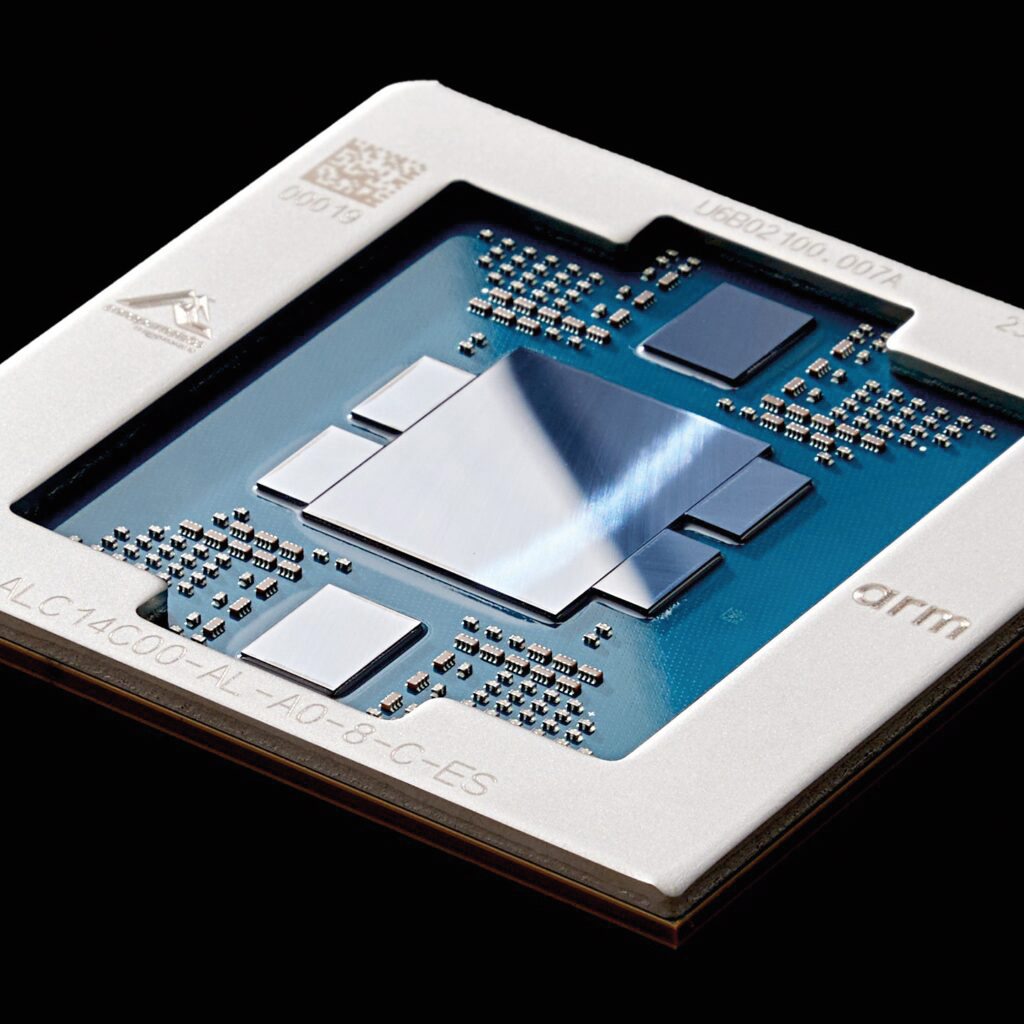

Drugi oralec ledine je seveda Amazon Web Services (AWS). Leta 2018 so predstavili prvi graviton, ki je zavrgel arhitekturo x86 in se preusmeril na 64-bitno arhitekturo ARM, slovečo po energetski učinkovitosti in hkratni zmogljivosti. Podjetje ima v ta namen hčerinsko podjetje Annapurna Labs. Kot so tedaj povedali, so podobno kot Google z razvijanjem lastnih procesorjev pridobili popoln nadzor nad optimizacijo zmogljivosti svojih storitev, kar je omogočilo boljšo prilagoditev procesorjev potrebam specifičnih delovnih obremenitev. Saj veste, umetne inteligence, big data in ostalega.

Gravitone snujejo v izraelskem podjetju Annapurna Labs, čigar soustanovitelj je nekdanji bošnjaški begunec Hrvoje Bilič.

Graviton je imel 16 jeder, zasnovanih na Arm Cortex-A72, podporo za instančne tipe A1 na AWS EC2, predvsem pa je bil optimiziran za aplikacije z manjšimi zahtevami po procesorski moči. Recimo za oblačne storitve z manjšimi zahtevami po procesni moči, kot so majhni spletni strežniki, mikrostoritve in razvojna okolja. Pod črto je treba dodati, da je bila prva generacija sicer cenovno dostopna, a je po zmogljivosti le zaostajala za tedanjimi rešitvami na arhitekturah x86.

Tri leta pozneje je podjetje predstavilo Graviton2, ki je temeljil na 7-nanometrski tehnologiji in je zmogel do 64 jeder Arm Neoverse N1. Zaradi manj nanometrov je bil energetsko precej učinkovitejši, predvsem pa se je izboljšala zmogljivost čipa, ki je začel za okoli 40 odstotkov prehitevati tedanje primerljive instance x86.

Tretja generacija, Graviton3, je bila uradno predstavljena leta 2021. Z uporabo jeder Arm Neoverse V1 je prinesla do dvakrat boljšo zmogljivost pri plavajoči vejici, do dvakrat hitrejšo kriptografsko izračunavanje in do trikrat boljšo zmogljivost na področjih strojnega učenja v primerjavi z Gravitonom2. Za pohitritev ni bilo zanemarljivo, da je Graviton3 začel podpirati tudi bolj prepusten pomnilnik DDR5.

Graviton4, trenutni sodobnik, napovedan na re:Invent 2023, je zasnovan na jedrih Neoverse V2 in prinaša do 30 odstotkov boljšo računsko zmogljivost, nosi za polovico več jeder in ima 75 odstotkov večjo pasovno širino pomnilnika v primerjavi s trojko.

V praksi so z gravitoni pridobili uporabniki Amazonovega oblaka EC2. Med znanimi sta SAP in Epic Games. Zadnji kot operater ene največjih nalinijskih iger na svetu, Fortnita z več kot 350 milijoni igralnih računov, uporablja instance Graviton4 za zagotavljanje hitre in zanesljive igralne izkušnje.

Microsoft

Pred poldrugim letom smo izvedeli, da tudi Microsoft že od leta 2019 v tajnosti razvija čipe za najnovejše velike jezikovne modele, kot je GPT-4. Kar pa ne čudi, saj je redmondski velikan v zadnjem desetletju postal ključni igralec na področju storitev v oblaku s svojo platformo Microsoft Azure.

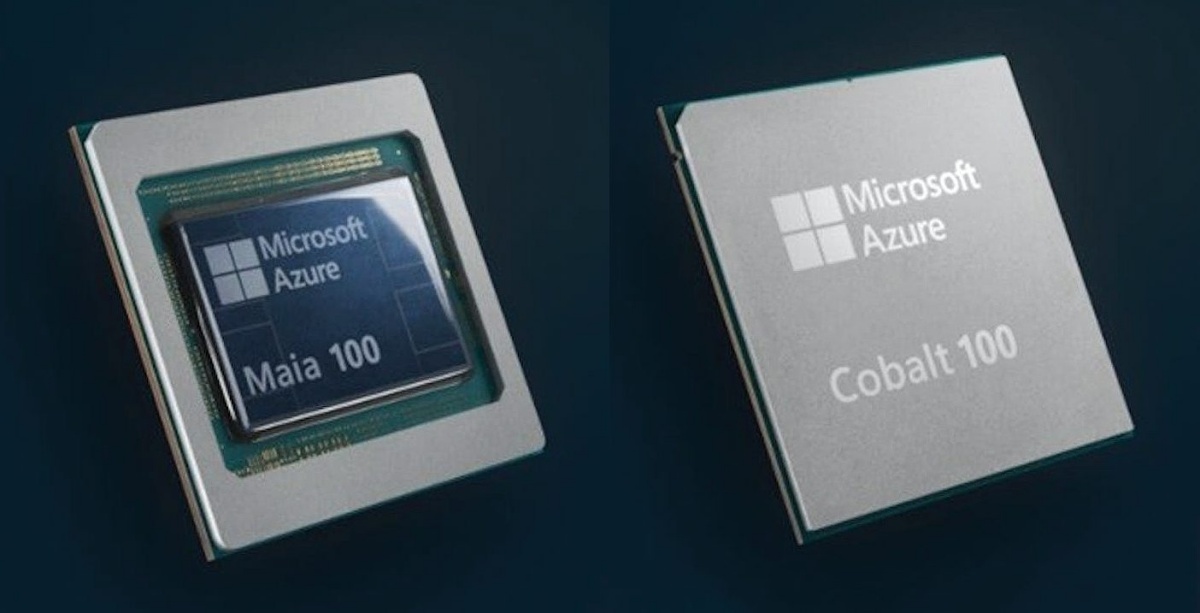

Microsoft se pri snovanju lastnih čipov preizkuša v več panogah. Poleg energetsko učinkovitih procesorjev za običajna opravila, je uspešen tudi z lastnimi pospeševalniki in varnostnimi koprocesorji.

Microsoft se je usmeril v razvoj lastnih čipov s poudarkom na treh glavnih področjih: procesorjih za umetno inteligenco, energetsko učinkovitih čipih za obdelavo v oblaku in varnostnih procesorjih.

Spomladi so tako predstavili Maia 100 AI Accelerator, ki naj bi bil tekmec Nvidijinemu H100. Gre za prilagojen procesor, namenjen pospeševanju storitev umetne inteligence v Azurovih podatkovnih centrih. Razvit je bil za podporo naprednim aplikacijam, kot so urjenje velikih modelov, računalniški vid, naravni jezik in nevronske mreže.

Maio 100 sicer izdeluje TSMC v svoji tehnologiji 5 nm, ki omogoča veliko gostoto tranzistorjev, s tem pa hitro obdelavo podatkov za urjenje in sklepanje umetne inteligence. V nasprotju s tekmeci se je Microsoft odločil za starejšo tehnologijo pomnilnika, na Maio so integrirali štiri pomnilniške čipe HBM2E s skupno 64 GB, ki omogočajo pasovno širino do 1,8 TB/s. Maia je zasnovana za obremenitve TDP (Thermal design Power) do 700 W, vendar optimizirana deluje že na 500 W, kar jo uvršča med energetsko učinkovite rešitve v svojem razredu. Poznavalci ocenjujejo, da Microsoft zaradi varčevanja pri pomnilniku morda res ne dosega glavnega konkurenta, a po drugi strani svoje čipe proizvaja precej, precej ceneje, kot če bi jih nabavljal pri Nvidii.

Druga spomladi predstavljena procesorska novost pa je Cobalt 100 CPU. V bistvu je to prvi Microsoftov procesor, razvit znotraj podjetja, temelji pa na arhitekturi ARM. V Microsoftovih podatkovnih centrih bo poganjal obdelavo splošnih oblačnih delovnih obremenitev s poudarkom na energetski učinkovitosti. Ima 128 jeder arhitekture Neoverse N2 in 12-kanalni pomnilnik DDR5, s čimer naj bi za približno 40 odstotkov povečal zmogljivosti v primerjavi s prejšnjimi procesorji ARM. Procesor je optimiziran za aplikacije, kot so Teams, Azure SQL in še nekatere druge storitve, podpira potrebe po visokozmogljivem računalništvu, hkrati pa ohranja energetsko učinkovitost.

Pri Microsoftu so sicer lastne čipe snovali že prej. Eden ključnih projektov na tem področju je Project Brainwave, ki je že kako desetletje usmerjen v pospeševanje nalog umetne inteligence v njihovih podatkovnih centrih. Project Brainwave je platforma, ki uporablja čipe FPGA (Field-Programmable Gate Arrays). Ti omogočajo realno časovno izvajanje kompleksnih algoritmov strojnega učenja.

Gre za čipe, za Microsoft jih sicer izdeluje Intel, zasnovane tako, da so preprogramljivi, z drugimi besedami, inženirjem omogočajo, da algoritme zapišejo neposredno na čip. Te pa je pozneje mogoče tudi spreminjati, če se zahteve v procesu spremenijo. Prednost tako hranjene programske kode pa je seveda tudi v tem, da v primerjavi s klasično procesno enoto ne uporablja nobenega posrednika, zato ni zakasnitev. Vse to omogoča izvajanje modelov umetne inteligence v realnem času, brez potrebe po vnaprejšnjem urjenju ali optimizaciji kode za določeno strojno opremo.

Čipi FPGA v resnici ne predstavljajo neke zaresne novitete, saj so jih v preteklosti že uporabljali za nekatere naloge, je pa novost njihova uporaba na področju pospeševanja umetnointeligenčnih modelov. Microsoftovi raziskovalci pa so pred časom ugotovili, da bi jih bilo mogoče uporabiti tudi za boj proti neizogibnemu koncu Moorovega zakona. Brainwave procesorji se uporabljajo na številnih ključnih točkah znotraj Azura, denimo pri storitvah, kot so prepoznava govora, obdelava naravnega jezika (NLP) in računalniški vid.

V tančice skrivnosti je že nekaj let zavit Projekt Athena, kjer poskušajo ob pomoči prilagojenih procesorjev optimizirati delovanje aplikacij v oblaku; predvsem tam, kjer potrebujemo hitre odgovore in majhno porabo energije. Microsoft je domnevno pospešil delo pri tem projektu, ni pa še jasno, kdaj bodo ti procesorji zares vpreženi v Azure.

Tu je še projekt Pluton. Gre za varnostni čip, ki je nato vgrajen v SoC. Zasnovan je bil za krepitev varnosti osebnih naprav, a je bil sprva uporabljen v podatkovnih centrih. Tam zagotavlja varno shranjevanje in obdelavo ključnih informacij, kot so šifrirni ključi, overitveni podatki in drugi občutljivi podatki, ki jih je treba zaščititi pred fizičnimi in kibernetskimi napadi. Vsi ti podatki so shranjeni znotraj procesorja in niso nikoli izpostavljeni zunanjim povezavam, kar bistveno zmanjšuje možnost njihovega prestrezanja.

Tak varnostni čip je integriran neposredno v CPU, kar pomeni, da ni več potrebe po ločenih varnostnih modulih, kot je tradicionalni TPM (Trusted Platform Module). Pluton pri tem skrbi za šifriranje podatkov, tako med prenosom kot v mirovanju. Plutona Microsoft proizvaja ob pomoči partnerjev – AMD, Intela in Qualcomma.

Apple

Čeprav bi kdo mislil nasprotno, je tudi Apple z leti postal močan ponudnik storitev v oblaku. Pri tem je podjetje v svojih podatkovnih centrih prav tako prešlo na uporabo lastnih procesorjev. Začelo pa se je seveda raven niže, pri njihovih izdelkih. Tako so leta 2020 začeli prehod s procesorjev Intel na lastno zasnovane procesorje Apple Silicon; znani so varčni in zmogljivi modeli iz serije M, ki temelji na arhitekturi ARM. Apple pa je že dolgo načrtoval razvoj lastne strojne opreme za svoje podatkovne centre in vlagal vanj, da bi izboljšal zmogljivost svojih storitev, kot sta iCloud in Siri.

Apple je po uspešnih lastnih čipov M z napovedanim ACDC pripravljen tudi na pohod v podatkovne centre. Na sliki M1 prve generacije.

Podjetje je ob že omenjenih generalnih ciljih, ki jih zasledujejo vsi, z lastnimi čipi želelo doseči tudi popoln nadzor nad svojo infrastrukturo, torej, da lahko učinkoviteje sinhronizirajo programsko opremo z namensko strojno opremo, zagotovo pa je bil stranski razlog tudi manjša odvisnost od zunanjih proizvajalcev, kot je Intel ali AMD.

Letos spomladi se je razvedelo, da je Apple v sodelovanju s podjetjem TSMC začel razvijati čipe, ki bodo v podatkovnih centrih poganjali programsko opremo za umetno inteligenco. Projekt, zvito poimenovan ACDC (Apple Chips in Data Center), je sicer skrivaj potekal že več let in naj bi bil del Applove strategije za povečanje umetnointeligenčne zmogljivosti v njihovih napravah in storitvah. Kot so poročali mediji, podjetje načrtuje, da bodo v naslednjih dveh letih v tovrstne strežnike vložili več kot pet milijard ameriških dolarjev. Ti čipi bi lahko igrali ključno vlogo pri izboljšanju umetnointeligenčnih funkcionalnosti v napravah, ki poganjajo prihodnje različice Applovih operacijskih sistemov. Poleg tega naj bi TSMC napredoval v razvoju 3-nanometrskega procesa izdelave procesorjev, pri čemer naj bi bil Applu pripravljen zagotoviti celotno proizvodno zmogljivost za te čipe.

Meta, znana tudi kot Facebook

Meta, ki gradi svoj jezikovni model Llama, je lani predstavila Meta Training and Inference Accelerator (MTIA), prvi umetnointeligenčni pospeševalnik, ki je bil zasnovan z mislijo na obremenitve, pisane na kožo ponudnika družbenih omrežij. Ta je bil ključen za izboljšanje računske učinkovitosti njihove infrastrukture, predvsem pa za podporo njihovim razvijalcem pri gradnji umetnointeligenčnih modelov.

Facebookov izziv je razvoj lastnega jezikovnega modela LLama. V ta namen so relativno pozno začeli z razvojem lastnih čipov MTIA.

Prva generacija, MTIA v1, je začela nastajati leta 2020 in temelji na 7-nanometrskem procesu, izdelovalec pa je TSMC. Čip je uporabljal pomnilniški podsistem LPDDR5, razpoložljivosti do 128 GB. Naslednja generacija, MTIA v2, je bila izdelana na 5-nanometrskem procesu, ima več procesorskih jeder in podvojen notranji pomnilnik. S tem so dosegli do 3-krat boljšo skupno zmogljivost v primerjavi z MTIA v1, kar je podjetju omogočilo izboljšanje modelov razvrščanja in priporočil za različne storitve, vključno z optimizacijo prikazovanje oglasov na Facebooku. A Metini lastni čipi so se v praksi vendarle izkazali slabše kot Nvidijini. Podjetje bo zato, kljub Metinemu lastnemu razvoju, v bližnji prihodnosti ostalo njihova močna stranka.

Meta je namreč svojo najnovejšo različico čipa MTIA že vključila v 16 svojih podatkovnih centrov po svetu, kjer predstavljajo približno polovico računske moči. Drugo polovico pa prispeva Nvidia. Mark Zuckerberg je v začetku leta napovedal, da bodo v njihovih rackih potrebovali okoli 350.000 Nvidijinih H100, kar se je pozneje najverjetneje pretvorilo v nekaj manj novejših čipov arhitekture Blackwell, ki so na trg prišli par mesecev zatem. Četrta iteracija LLame bo namreč potrebovala desetkrat več procesorskih virov kot predhodnica, LLama 3.

Kaj pa slabe plati?

Zakaj torej vsi, ki imajo v lasti podatkovne centre, ne vlagajo v lastne računske sile? No, pa saj poznate odgovor: začetni stroški razvoja so enormni in si jih zato lahko zares privoščijo samo veliki. Pa še ti pod pogojem, da imajo resne vnaprejšnje načrte, kako si bodo ta denar povrnili. Poleg tega morajo biti podjetja, ki se odločijo za to pot, pripravljena na to, da bo ta trajala nekaj let. Razvoj takšnih procesorjev je pogosto dolgotrajen proces, ki zahteva veliko učenja na napakah ter stalne izboljšave in posodobitve.

Drugi minus je ozka opravilna usmerjenost. Večina čipov ASIC je optimizirana za specifične naloge. Kot smo videli, je trenutno modno strojno učenje, po drugi strani pa niso uporabni za vse vrste splošnih računalniških nalog, kjer jih še vedno prekašajo klasični CPU in GPU.

Kraljica za zdaj ostaja na tronu

Nvidia je lani na trg poslala rekordnih 3,76 milijona čipov, namenjenih delovanju v podatkovnih centrih, kar je reci in piši 42-odstotna rast v primerjavi z letom 2022. To je podjetju omogočilo, da je obdržalo 98-odstotni tržni delež na področju GPU za podatkovne centre.

Uspeh je delno posledica naraščajočega povpraševanja po umetni inteligenci, ki je podjetju prineslo 60,9 milijarde dolarjev prihodkov v letu 2023, kar je 126 odstotkov več kot leto prej, pri čemer tudi zanje velja prepoved izvoza umetne inteligence in drugih naprednih čipov na Kitajsko.

Vendar pa Nvidia še zdaleč ni brez izzivov, čeprav se njihovi predstavniki radi pohvalijo, da izdelki konkurentov še vedno niso tako zmogljivi kot njihovi, zlasti ko gre za delo z umetno inteligenco. Ampak nasprotniki ne spijo. AMD je ravno dostavil peto generacijo procesorjev EPYC, imenovano Turin, ki žanjejo dobre rezultate na preizkusih in so obenem po varčnosti izziv za Nvidijin H100 GPU, ki pri polni zmogljivosti porabi 700 W energije. Intel prav tako promovira svoj nedavno predstavljeni procesor Gaudi 3 AI , ki bo stal polovico Nvidijinega H100, kar je privlačna ponudba za podjetja, če vemo, da je cena H100 trenutno nekje okoli 30.000 ameriških dolarjev na enoto. Open AI, Nvidijina pomembna stranka, prav tako dela prve korake lastnega razvoja v partnerstvu z Broadcommom. A za zdaj ne preveč uspešno.

Potem je tu še kopica manjših proizvajalcev čipov, kot je Cerebras, ki v partnerstvu z Qualcommom že posega v najzahtevnejše segmente tega trga. Drugi je Ampere, kjer so spomladi napovedali novo družino strežniških procesorjev, izdelanih na arhitekturi ARM.

Še en tak startup je Groq, ki bo prihodnje leto izdal svoj čip najnovejše generacije. Pa potem Tenstorrent, ki ima močnega aduta v svojem predsedniku uprave. Jim Keller je delal za Apple, AMD, Tesla in Intel ter pomagal snovati Zen arhitekturo pri AMD, še prej pa čipe za prve generacije Applovih ipadov in iphonov.

Kako bi se svet vrtel danes, če bi Nvidii pred štirimi leti uspel prevzem ARM, pa si lahko samo predstavljamo.